Contents

Mit dem Indexierungsstatus Probleme identifizieren

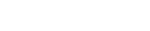

Unter dem Punkt Indexierungsstatus zeigt eine Grafik die Anzahl der Seiten, die durch Google im Zeitverlauf insgesamt indexiert wurden. Bei neu indexierten Seiten kann die Aufnahme in der Google Search Console etwas dauern, da die Google Search Console kein Echtzeit-Tool ist. Die in der Grafik abgebildete Indexierungskurve eignet sich dazu, um Probleme bei der Indexierung zu identifizieren.

Die Indexierungskurve fällt

Eine Indexierungskurve die einen Einbruch aufweist, kann auf folgende Ursachen hinweisen:

- Verwendung von meta=”noindex”

- URL Struktur hat sich geändert

- Serverprobleme

Die Indexierungskurve steigt

Eine steigende Indexierungskurve ist vor allem bei einer neu aufgesetzten Seite tendenziell ein gutes Zeichen, da hier neue Inhalte gecrawlt werden und in den Index gelangen.

Wurden keinen neuen Seite erstellt und die Anzahl der indexierten Seiten steigt trotzdem, könnte dies ein Anzeichen dafür sein, dass Crawler-Anweisungen nicht richtig funktionieren oder entfernt wurden.

Mit dem erweiterten Indexierungsstatus nicht crawlbare URLs anzeigen lassen

Neben dem einfachen Indexierungsstatus kann auch der erweiterte Indexierungsstatus angezeigt werden. In diesem Modus wird auch die Anzahl der URLs angezeigt, die durch die robots.txt blockiert werden. Durch die robots.txt blockierte URLs werden vom Crawler nicht gecrawlt und können daher nicht in den Index gelangen.

Ein Anstieg von blockierten URLs führt nicht zwangsläufig zu einem Rückgang der indexierten Seiten. Denn durch die robot.txt können Seiten vom Crawling ausgeschlossen sein, die ohnehin eine Noindex-Anweisung enthalten und somit schon vor der Blockierung von der Indexierung ausgeschlossen waren. Eine Blockierung solcher Seiten kann Sinn machen, um Crawler Budget einzusparen.

Content Keywords – Begriffe überprüfen

Update: Dieser Bericht wurde am 28.11.2016 entfernt und steht damit nicht mehr zur Verfügung. (Quelle)

Unter dem Punkt Content Keywords werden Keywords aufgelistet die am häufigsten auf der Webseite vorkommen. Mit einem Klick auf das Keyword gelangt man zu den 10 Top Seiten, die das Keyword am häufigsten enthalten. Außerdem werden die Varianten zum Keyword angezeigt, die ebenfalls von Google berücksichtigt werden.

Der Vorteil ist, dass man sehen kann, wie Google die Seite interpretiert. Werden Keywords angezeigt, die mit der eigentlichen Webseite nichts zu tun haben, wie Beispielsweise „Potenzmittel“, kann dies ein Indiz für eine gehackte Webseite sein.

Blockierte Ressourcen – Google möchte die Seite zu 100% verstehen

Hier werden Ressourcen angezeigt die von dem Google Crawler nicht gecrawlt werden können und damit nicht optimal gerendert werden. Durch das Rendern kann Google nachvollziehen, wie die Webseite im Browser dargestellt wird. Google möchte so gut wie es geht, die Seite verstehen, um die bestmöglichen Suchergebnisse anzubieten. Das Rendern ist eine Maßnahme für Google, um die Webseite zu interpretieren.

Damit Google die Seite rendern kann, sollten folgende Ressourcen dem Crawler zugänglich sein:

- JavaScript-Dateien

- CSS-Dateien

- Bilddateien

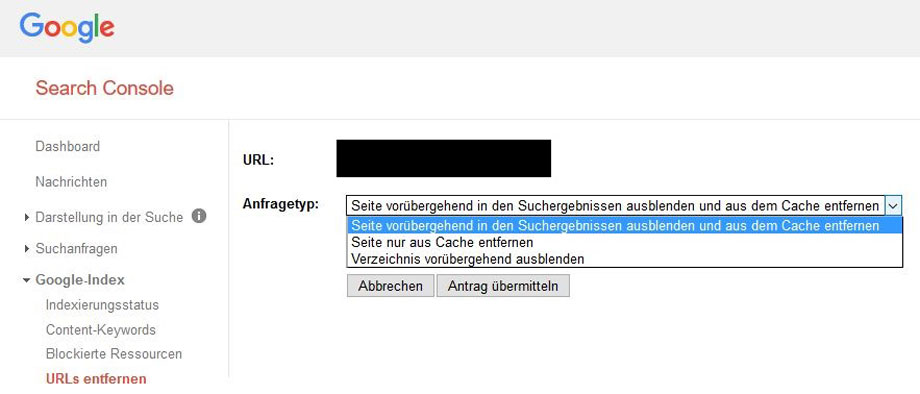

URLs entfernen

Es kann immer wieder vorkommen, dass URLs zeitnah entfernt werden müssen. Die Google Search Console bietet im Bericht „URLs entfernen“ die Möglichkeit dazu.

Zu beachten ist, dass die URLs nur vorübergehend aus den Google Suchergebnissen entfernt werden. Da Google nicht das Web ist, müssten weitere bzw. andere Schritte vollzogen werden, damit die URL nicht im Web erscheint.

Nachdem die URL eingegeben wurde und auf „weiter“ geklickt wurde erscheint folgende Seite:

Hier wird der Anfragetyp ausgewählt. Die Löschung für Seiten und Verzeichnisse besteht für mindestens 90 Tage. Also mindestens 90 Tage lang wird die eingereichte Seite oder das Verzeichnis nicht in den Google Suchergebnissen angezeigt. Danach wird der Crawler wieder versuchen die Seite zu crawlen. Um zu verhindern, dass die Seite oder das Verzeichnis wieder in den Google Suchergebnissen erscheint, ist einer der folgenden Schritte notwendig:

- Seite spielt 404 Fehler aus

- Seite spielt 410 Fehler aus

- Auf Seite wurde Noindex-Tag eingebunden

Nachdem der Antrag übermittelt wurde, dauert die Bearbeitung durch Google in der Regel 1 Tag. Es gibt keine Garantie, dass der Antrag angenommen wird.

Fazit – Schnelle Überprüfung der Indexierung möglich

Die Google Search Console bietet hilfreiche Berichte, um die Indexierung zu überwachen und zu beeinflussen. Dies ist eine Voraussetzung für die Suchmaschinenoptimierung, denn nur URLs die indexiert sind, können in den Google Suchergebnissen angezeigt werden. Müssen Seiten zeitnah aus dem Google-Index entfernt werden, hilft der Bericht „URLs entfernen“ weiter.

Sie haben Fragen zur Google Search Console oder benötigen professionelle Unterstützung? Als mehrfach zertifizierte SEO-Agentur sind wir bei clicks digital Ihr idealer Ansprechpartner. Nehmen Sie dafür einfach Kontakt zu uns auf.