Was ist ein Crawler?Crawler sind Computerprogramme die das Internet automatisiert nach Inhalten durchsuchen. Die gefundenen Inhalte (Webseiten) werden vom Crawler heruntergeladen und abgespeichert. Die abgespeicherten Kopien werden dann mit Hilfe von Algorithmen ausgewertet und in den Suchergebnissen angezeigt, sofern keine Anweisung für eine Nichtindexierung vorhanden ist.

Um Inhalte zu finden, folgen Crawler den Links von Webseiten. Crawler werden unter anderem als Webcrawler, Spider, Bot oder als Searchbot bezeichnet. Je nach Verwendungszweck gibt es unterschiedliche Crawler. Der am meisten verwendete Crawler von Google ist der Googlebot, der für die Websuche verwendet wird. Eine Übersicht über die Crawler von Google gibt es auf support.google.com.

Contents

- Crawling Budget und Crawling Frequenz: Wie oft wird meine Seite gecrawlt?

- Crawler per robots.txt steuern

- Wann sollten die Meta Tags Noindex/Nofollow eingesetzt werden?

- Mit Canonical Tag das Crawling effektiver machen

- Meta-Tags, robots.txt und Canonical Tag – wann verwende ich was?

- Google Search Console – Crawler überwachen und steuern

- Fazit: Crawlingbudget effizient steuern

Crawling Budget und Crawling Frequenz: Wie oft wird meine Seite gecrawlt?

Durch Algorithmen werden das Crawling-Budget und die Crawling-Frequenz für jede Domain festgelegt. Die Frequenz mit der eine Webseite gecrawlt wird, hängt unter anderem von der Häufigkeit der Aktualisierung der Webseite ab. Es wird angenommen, dass das Crawling-Budget von Faktoren wie dem Trust, also der Vertrauenswürdigkeit einer Seite, bestimmt wird. Mit der Begrenzung des Crawlings ist Google daran interessiert nur die wichtigsten Seiten zu crawlen und Ressourcen zu sparen. Denn selbst wenn das Indexierungsbudget vor kurzem erhöht wurde, sind auch die Ressourcen von Google begrenzt.

Die Steuerung des Crawlers ist damit vor allem für eine Domain mit vielen Unterseiten wichtig. Neben einer flachen Seitenstruktur, der Einreichung von Sitemaps, der Vermeidung von 404 Fehlern und Weiterleitungsketten hat ein Webseitenbetreiber mehrere Möglichkeiten einen Crawler zu steuern.

Crawler per robots.txt steuern

Für den User unwichtige Inhalte sollten vom Crawling ausgeschlossen werden. Dafür eignet sich die robots.txt, die für alle seriösen Suchmaschinen Crawler relevant ist. Mit der Anweisung „Disallow:“ können Verzeichnisse einer Webseite, bestimmte Suchmaschinen und bestimmte Crawler ausgeschlossen werden. Die genauen Anweisungen und alles Wissenswerte zur robots.txt gibt es im Beitrag robots.txt vs. Meta-Tag “robots”. Die Robots.txt kann mit der Google Search Console auf Fehler getestet werden. Der „robots.txt tester“ befindet sich im Menüpunkt „Crawling“.

Wann sollten die Meta Tags Noindex/Nofollow eingesetzt werden?

Des Weiteren können mit den Meta-Tag Befehlen Nofollow und Noindex dem Crawler Anweisungen übergeben werden. Mit dem Meta-Tag NoFollow wird dem Crawler gesagt, den Links auf der Seite nicht zu folgen. Mit dem Meta-Tag Noindex wird dem Crawler übermittelt, die Seite nicht in den Index mit aufzunehmen.

Die Einbindung von Noindex/Nofollow Anweisungen bietet sich bei folgenden URLs an:

- URLs aufgrund von Suchfunktionen (Shopsuche, Produktsuche etc.)

Durch die Suchfunktion wird bei jedem Suchbegriff eine neue URL erzeugt. Ein Crawling und die Indexierung von solchen Seiten machen keinen Sinn.

Die Einbindung von Noindex/Follow Anweisungen bietet sich bei folgenden URLs an:

- Paginierungsseiten

- Parameter URLs

- Filter URLs wie beispielsweise Produktfilter

Solche URLs werden auf Follow gesetzt, damit die verlinkten Seiten mit Linkpower versorgt werden. Um Duplicate Content Probleme zu vermeiden, werden diese URLs auf Noindex gesetzt. Außerdem sollte per Canonical auf die „richtige“ Seite verwiesen werden.

Mit Canonical Tag das Crawling effektiver machen

Der Canonical Tag wird wie der Meta Tag im Head Bereich eines HTML Dokument integriert. Mit dem Canonical-Tag wird der Crawler auf die „richtige“ Webseite, die sogenannte kanonische URL gleitet. Der Canonical wird häufig bei folgenden URLs eingesetzt:

- Paginierungsseiten

- Parameter URLs

- Filter URLs wie beispielsweise Produktfilter

Meta-Tags, robots.txt und Canonical Tag – wann verwende ich was?

Meta-Tags und Anweisungen in der robots.txt gleichzeitig zu verwenden, macht für HTML Dokumente keinen Sinn, da die robots.txt im Hauptverzeichnis abgelegt wird. Der Crawler nimmt somit als erstes die Anweisungen in der robots.txt war. Wurden nun Seiten vom Crawling durch die robots.txt ausgeschlossen, werden diese nicht gecrawlt und somit auch nicht die Meta-Tag Angaben in der HTML berücksichtigt. Das Gleiche wie für Meta-Tags gilt für Canonical-Tags.

Die Meta-Tag Anweisungen sind den Anweisungen in der robots.txt für HTML-Dateien zu bevorzugen. Dies hat mehrere Gründe. Zum einen wird eine URL die sich schon im Index befindet und nachträglich in der robots.txt gesperrt wird, nicht automatisch aus dem Index verschwinden. Des Weiteren können in der robots.txt blockierte Webseiten trotzdem im Index erscheinen, wenn die blockierte Webseite von anderen Seiten verlinkt wird und Google die Verlinkungen als relevant interpretiert. Da die blockierte Webseite durch die robots.txt Anweisung nicht gecrawlt werden darf, wird als Title der Linktext vom Link verwendetet und eine standardisierte Meta-Description in den Suchergebnissen ausgespielt.

Der Canonical-Tag ist für den Crawler keine Muss-Anweisung sondern eine Kann-Anweisung, die in der Regel fast immer befolgt wird. Wichtig ist, dass die Seite auf die der Canonical-Tag verweist (kanonische URL) einen ähnlichen Inhalt zur Ursprungsseite aufweist. Seiten mit einem Canonical-Tag zu einer anderen Seite, werden nicht indexiert. Es gibt keine herrschende Meinung darüber, ob eine URL, die nicht in den Index gelangen soll, einen Canonical-Tag oder ein Noindex erhalten soll. Wer auf Nummer sicher gehen möchte, verwendet beide Varianten, also Meta-Tag und Canonical-Tag gleichzeitig. Wichtig ist, dass im HTML-Code zuerst der Meta-Tag angegeben wird und dann der Canonical-Tag.

Google Search Console – Crawler überwachen und steuern

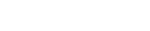

Die Google Search Console steht jedem Webseitenbetreiber kostenlos von Google zur Verfügung. Über dem Menüpunkt Crawling kann der Crawler überwacht und gesteuert werden.

Crawling Fehler erkennen

Im Menüpunkt „Crawling Fehler“ werden die Crawling-Fehler für Webseiten der letzten 90 Tage in Form von Webseite-Fehler und URL-Fehler angezeigt. Bei Website-Fehler wird zwischen den Fehlertypen „DNS“, „Serververbindung“ und „Abruf von robots.txt“ unterschieden. Werden hier Fehler angezeigt, kann das Crawling der Webseite gestört sein.

Crawling-Statistiken abrufen

Neben den Crawling-Fehlern können auch Probleme über die Crawling-Statistiken ausfindig gemacht werden. Laut Google gibt es keine „gute“ Crawling-Frequenz aber die Frequenz sollte relativ gleichmäßig verlaufen. Ein plötzlicher Abfall deutet auf Probleme im Crawling hin, die in einer hohen Ladezeit oder in blockierten Inhalten zu finden sind.

Ein Anstieg der Crawling-Frequenz ist mit der Veröffentlichung von neuen Inhalten zu erklären. Eine zu hohe Crawling-Frequenz kann zu einer Überlastung des Servers führen. Sollte dies der Fall sein, kann die Crawling-Frequenz in der Google Search Console angepasst werden. Dafür muss in den Website-Einstellungen die Maximale Crawling Frequenz beschränkt werden.

Die Crawling-Frequenz sollte nur kurzfristig beschränkt werden, da über die Beschränkung dem Google Crawler nicht mitgeteilt wird, welche Seiten gecrawlt werden sollen und welche nicht.

Crawling simulieren: Abrufen wie durch Google

Mit dem Tool „Abrufen wie durch Google“ können für einzelne Seiten das Crawling simuliert und damit überprüft werden. Häufigste Fehlermeldungen sind blockierte Ressourcen.

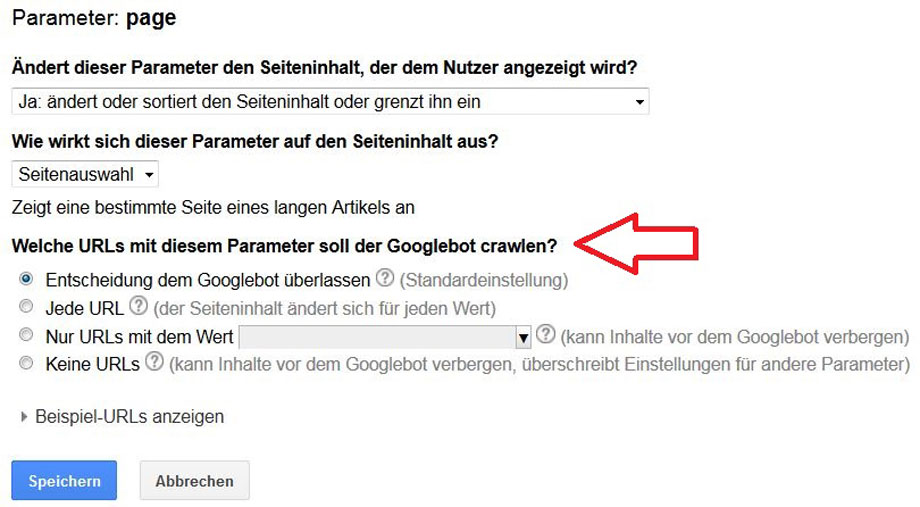

URL Parameter von Indexierung ausschließen

Parameter URLs entstehen häufig durch Filterfunktion und sind durch ein Fragezeichen in der URL zu erkennen. Beispiel: www.beispiel.de/produkt?ausstattung=2. Parameter URLs verursachen in der Regel Duplicate Content und sollen daher nicht indexiert werden. In der Google Search Console können die Parameter hinterlegt werden und für jeden Parameter das Crawlingverhalten festgelegt werden.

Fazit: Crawlingbudget effizient steuern

Webmaster und Shopbetreiber sollten steuern und überwachen, welche Seiten einer Domain in den Index von Suchmaschinen aufgenommen werden. Die Steuerung des Crawlers ist ein wichtiger Teil der Suchmaschinenoptimierung. Der Crawler kann vor allem über die robots.txt, Nofollow/Noindex, Canonical-Tags und über die Google-Search Console gesteuert werden. Für HTML-Dokumente ist die Verwendung von Nofollow/Noindex bzw. Canonical-Tags gegenüber Anweisungen in der robots.txt zu bevorzugen.