Contents

- Crawling Fehler ausfindig machen

- Crawling Statistiken – Der Überblick

- Crawling überprüfen und URLs schnell indexieren

- Robots.txt mit den Robots.txt Tester auf Fehler prüfen

- Sitemaps einreichen und testen

- URL-Parameter festlegen

- Fazit – Vielfältige Anwendungsmöglichkeiten um den Crawler zu steuern und zu prüfen

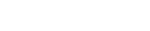

Crawling Fehler ausfindig machen

Im Bericht „Crawling Fehler“ werden zwischen Websitefehlern und URL Fehlern unterschieden. Websitefehler betreffen die gesamte Webseite und URL Fehler beziehen sich auf eine spezielle URL.

Als URL-Fehlermeldung werden am häufigsten 404 Fehler angezeigt. Ein 404 Fehler liegt vor, wenn eine Seite nicht verfügbar ist. Eine Seite ist zum Beispiel dann nicht mehr verfügbar, wenn eine bestehende URL gelöscht wurde oder ein Link auf eine nicht vorhandene URL gesetzt wurde. 404 Fehlerseiten werden nicht indexiert. Da Verlinkungen zu 404 Fehlerseiten keine Linkpower vererben, sollte überprüft werden, ob 301 Weiterleitungen notwendig sind.

Wurde der 404 Fehler behoben oder ist eine Behebung nicht notwendig, kann dieser in der Google Search Console als korrigiert markiert werden. Der 404 Fehler wird dadurch aus dem Bericht „Crawling Fehler“ entfernt.

Auch als korrigiert markierte 404 Fehler werden von Google nach einiger Zeit wieder gecrawlt. Daher können diese URLs wieder in der Google Search Console als 404 Fehler auftauchen, wenn weiterhin ein 404 Fehler vorliegt. Google crawlt in bestimmten Zeitabständen 404 Fehlerseiten, um zu prüfen, ob die 404 Fehlerseite aufrufbar ist und somit in den Index gelangen kann.

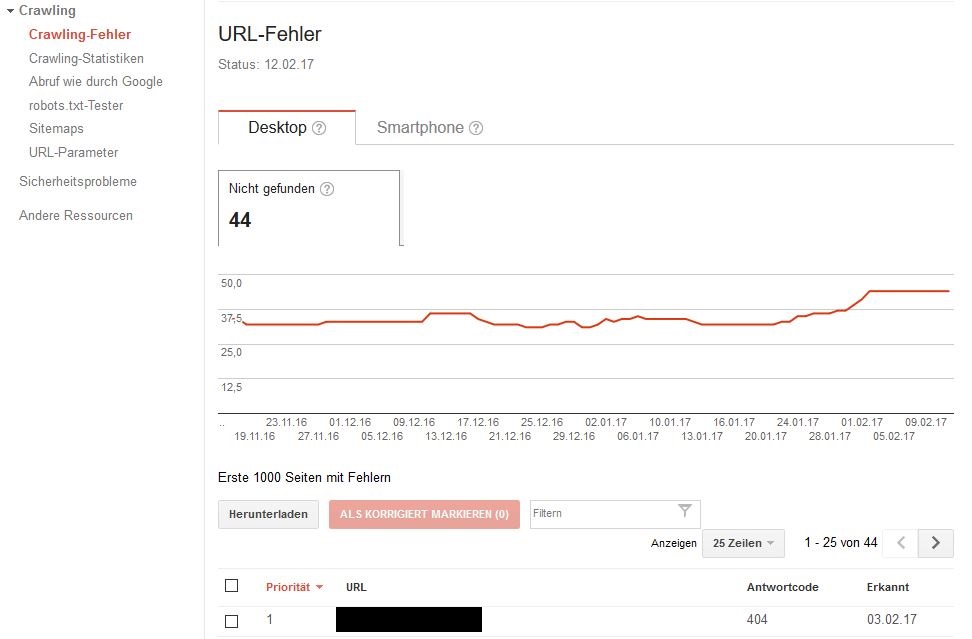

Crawling Statistiken – Der Überblick

Im Bericht Crawling-Statistiken werden die Googlebot-Aktivitäten der letzten 90 Tage in Form von

- Pro Tag gecrawlte Seiten

- Pro Tag heruntergeladene Kilobyte

- Dauer des Herunterladens einer Seite (in Millisekunden)

angezeigt. Die Crawling Frequenz ist kein Ranking-Signal und hat keine Auswirkungen auf den Traffic einer Webseite. Die maximale Crawl-Frequenz wird durch die Geschwindigkeit des Servers und durch die Anzahl der Servererrors, die der Crawler beim crawlen erhält, bestimmt. Eine stark gesunkene oder gestiegene Crawling Frequenz kann auf Probleme hindeuten.

Crawling Frequenz ist gesunken

Eine stark gesunkene Crawling Frequenz kann folgende Ursachen haben:

- In der robots.txt wurden neue Regeln hinzugefügt, die das Crawling von Seiten blockieren

- Server ist überlastet oder die Fehlerquote ist angestiegen

- Maximale Crawling-Frequenz wurde in der Google Search Console gesenkt

- Inhalte auf der Seite werden nicht regelmäßig aktualisiert oder die Seite besitzt keine hohe Qualität

Crawling Frequenz ist gestiegen

Werden viele neue Seiten veröffentlicht und/oder ranken viele Seiten die sehr beliebt sind, kann die Crawling Frequenz in ungewolltem Ausmaß steigen. Sollte der Eindruck entstehen, dass der Server überlastet ist, kann die Crawling Frequenz durch folgende Maßnahmen reduziert werden:

- In der robots.txt-Datei Seiten blockieren, die nicht aufgerufen werden sollen

- Crawling-Frequenz in der Search Console anpassen. Dies ist jedoch keine langfristige Lösung, da Google nicht erfährt, welche Seiten gecrawlt werden sollen und welche nicht

- Seiten mit unendlichen Ergebnissen wie zum Beispiel Suchseiten vom Crawling ausschließen. Entweder durch Anweisung in robots.txt oder durch NoFollow-Tags.

Crawling überprüfen und URLs schnell indexieren

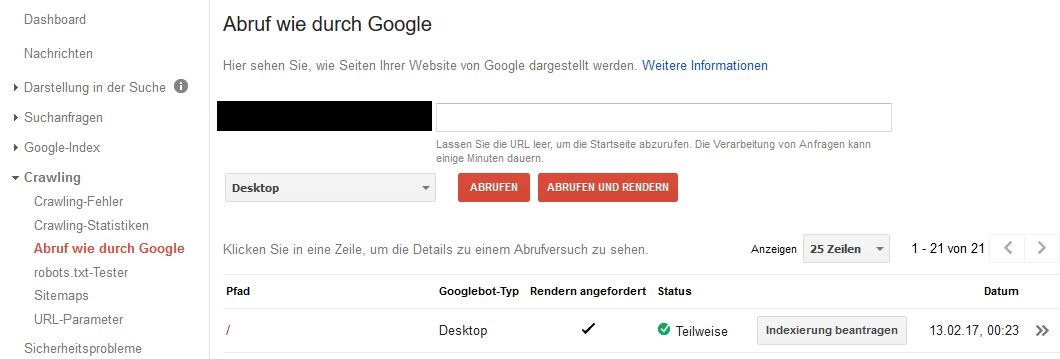

Im Bericht „Abruf wie durch Google“ wird dargestellt, wie der Googlebot die Webseite sieht. Dadurch kann geprüft werden, ob der Crawler Ihre Webseite vollständig crawlen kann. Kann die Webseite nicht vollständig abgebildet werden, sind meist Ressourcen wie beispielsweise CSS-Dateien blockiert. Die blockierten Ressourcen werden in der Google Search Console aufgelistet.

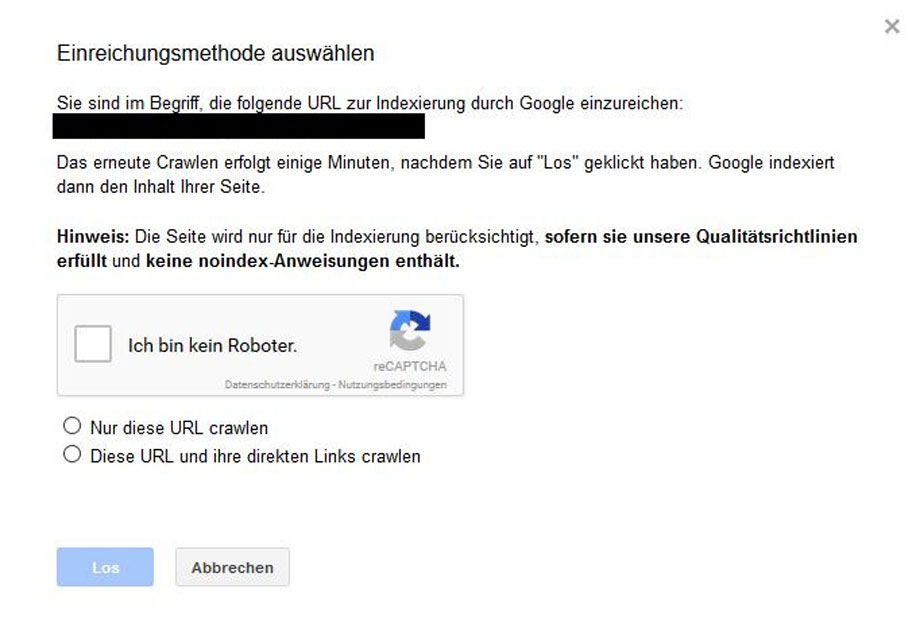

Des Weitern können für URLs die Indexierung beantragt werden, indem der Crawler angefordert wird. Dies ist praktisch, wenn Anpassungen an der Seite durchgeführt wurden, oder eine neue Seite schnell in den Google Index gelangen soll. Das Crawling der Seite erfolgt wenige Minuten nach der Beantragung der Indexierung.

Beim Antrag der Indexierung kann ausgewählt werden, ob nur die einzelne URL gecrawlt werden soll oder die URL mir ihren direkten Links.

Monatliches Crawling-Budget

- Crawling von einzelnen URLs: Maximal 500 einzelne URLs können pro Monat eingereicht werden.

- Crawling von URL und ihren direkten Links: Maximal 10 URLs können pro Monat eingereicht werden

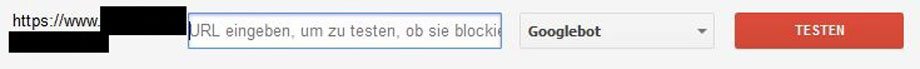

Robots.txt mit den Robots.txt Tester auf Fehler prüfen

Der Robots.txt Tester untersucht die vorhandene robots.txt und gibt Fehler und Warnmeldungen an. Außerdem können einzelne URLs getestet werden, ob diese von den robots.txt Anweisungen blockiert oder zugelassen werden. Dies macht vor allem dann Sinn, wenn in der robots.txt sehr viele Anweisungen vorhanden sind.

Sitemaps einreichen und testen

Eine Sitemap kann das Crawling einer Seite unterstützen, dies gilt vor allem für Websiten mit vielen URLs. Im Bericht Sitemap können Sitemaps hinzugefügt und getestet werden. Folgende Obergrenzen pro eingereichter Sitemap müssen eingehalten werden:

- 10 MB (unkomprimiert)

- 50.000 URLs

Werden diese Obergrenzen überschritten, können die Sitemaps aufgeteilt werden.

Neben dem hinzufügen können die Sitemaps auf Fehler getestet werden. Fehler sind z.B. Leere Sitemap, URLs zur Sitemap nicht zugänglich und ungültige Datumsangaben.

URL-Parameter festlegen

URL-Parameter werden am Ende der URL mit einem Fragezeichen (?) eingefügt. Sie entstehen vor allem bei Filtern, wie zum Beispiel bei Preisfiltern oder Farbfiltern. Ein Beispiel für einen URL Parameter wäre ?sale=true in folgender URL:

https://www.beispiel-domain.de/herrenbekleidung-kleider/?sale=true

Parameter URLs können Duplicate Content verursachen. Google clustert dann die doppelt vorhandenen Seiten und wählt die URL, die das Cluster am Besten repräsentiert. Nicht immer gelingt es Google die passende URL auszuwählen. Im Bericht URL-Parameter können Parameter entsprechend konfiguriert werden, um Google zusätzliche Informationen zu geben.

Fazit – Vielfältige Anwendungsmöglichkeiten um den Crawler zu steuern und zu prüfen

Das Crawling einer Webseite lässt sich durch verschiedene Maßnahmen prüfen und steuern. Bereits als korrigiert markierte 404 Fehler erscheinen nach einem bestimmten Zeitabstand wieder in der Google Search Console. Dies ist kein Grund zur Sorge, denn selbst korrigierte 404 Fehler werden in bestimmten Zeitabständen von Google überprüft.

Für einzelne URLs kann die Indexierung beschleunigt werden. Dies ist vor allem bei Änderungen und neuen Seiten sehr nützlich. Die Crawl-Frequenz, Sitemap, robots.txt und das Abrufen wie durch Google bieten weitere Überprüfungen des Crawlings.