Contents

- Keynote mit Rand Fishkin

- Schnell ist zu langsam: Einmal um die Welt und das in Höchstgeschwindigkeit (Bastian Grimm, Bartosz Góralewicz)

- Amazon PPC: Von Strukturen zu programmatischen Kampagnen und Retargeting (Trutz Fries, Désirée-Sina Kellner)

- Diesmal wird es ernst: die Roboter kommen und alles wird sich ändern (Jim Sterne)

- Das Ende von Exact Match? Taktiken für die negative Keyword Automatisierung (Christopher Gutknecht)

- Zielgruppenansprache in einer datenschutzorientierten Welt (Dr. Martin Schirmbacher)

- Fragt die SEA-Experten! (Brad Geddes, Martin Röttgerding, Frederick Vallaeys)

- Quantität vor Qualität? Human versus Machine? Ein Blick in die Blackbox der Automatisierung von Google Ads (Oliver Greifenstein, Oliver Zenglein)

- Wenn die Technologie unser Leben bestimmt – Überlebensstrategien für eine neue Ära (Karl Gilis)

- Was haben die anderen, was ich nicht habe? Die Macht der vergleichenden Content-Analyse – Benchmarking und Tools (Fionn Kientzler)

- Large Scale SEA – Prozess einer Inhouse Lösung (Rasmus Porsgaard)

- Recruiting 2020: Storytelling & Branding mit Social Ads (Yannick Lott)

- Sherlock Holmes der Daten oder die Kunst der Interpretation (Tom Alby)

- Produktentwicklung mit Machine Learning und KI: Chancen und Herausforderungen (Shalini Sukumar)

- Technical Onpage & Onsite Clinic (Website Clinic m. John Müller)

- Experiment SEO Kannibalisierung (Jason Paget, Ross Tavendale)

- Predictive SEO (Sebastian Erlhofer)

- SEO Prozessoptimierung & Automatisierung (Jens Fauldraht)

- Erste Erkenntnisse zum Google March 2019 Core Update und Nichts geht ohne Daten: Dekonstruktion, Kreation und Einsatz von gutem Content (Marcus Tober)

- So fand Katharina die diesjährige SMX

- Weitere Recaps der SMX München 2019

Keynote mit Rand Fishkin

Rand Fishkin hat es mal wieder geschafft: Er brachte eine Keynote zur SMX mit, die nicht nur unterhalten, sondern auch inhaltlich inspiriert hat.

Ausgangspunkt war ein ziemlich düsteres Bild: Alle großen Web-Riesen ziehen sich immer mehr in einen Walled Garden zurück und tun sehr viel dafür, den Traffic-Fluss nach außen zu beschränken:

- 2017 war das erste Jahr, in dem Google trotz steigender Nutzungsintensität weniger Traffic nach außen gelassen hat: Vor allem deshalb, weil Google viele Fragen direkt beantwortet.

- Facebook entwickelt den News Feed Algorithmus weiter und sorgt vor allem bei der organischen Reichweite dafür, dass Nutzer seltener mit Marken in Kontakt kommen und durch deren gepostete Links die Plattform verlassen.

- YouTube behält die Video Descriptions bei und gestattet auch weiterhin Links: Allerdings werden diese ausgeblendet und daher nur noch selten wahrgenommen.

- Es gibt mehr und mehr Influencer, die ihre Rolle nicht professionell erfüllen.

- steigende Anzeigen-Klichpreise und sinkender ROAS

Tatsächlich ist ein Trend zu beobachten, wonach die meisten Top Referrer Webseiten in Deutschland von Jahr zu Jahr weniger Traffic nach außen lassen. Ausnahmen bilden lediglich sehr stark wachsende Plattformen wie Pinterest.

Was also tun, um als Online Marketer weiterhin erfolgreich Website-Besucher zu generieren? Rand Fishkin gab darauf eine Reihe von Antworten. Die überzeugendsten davon waren:

- Schaut euch die Google SERPs genau an und prüft, welche Suchergebnisseiten tatsächlich noch das Potenzial zeigen, Klicks zu generieren.

- Arbeitet daran, dass das Suchvolumen für eine ganz bestimmte Suchanfrage steigt: euren Markennamen

- Schaut euch genau an, auf welchen Kanälen eure Wettbewerber nicht unterwegs sind: In der Regel stehen dort Werbewirkung & Werbekosten in einem deutlich besseren Verhältnis, sofern eure Zielgruppe dort auch unterwegs ist.

- Vergesst den Hype um Follower und Reach. Hinterfragt lieber, wo eure Zielgruppe wirklich unterwegs ist und intensiviert dort eure Bemühungen.

- Sorgt dafür, dass teuer eingekaufte Besucher ihre Kontaktdaten hinterlassen und ihr euch zukünftig selbst einen reichweitenstarken Kanal aufbaut: beispielsweise via Mail

Schnell ist zu langsam: Einmal um die Welt und das in Höchstgeschwindigkeit (Bastian Grimm, Bartosz Góralewicz)

Im ersten Teil des Vortrags gab es Basics zu Website Rendering und Stolperfallen beim Einsatz von JavaScript (welche die Ladezeiten in die Höhe treiben können). Zudem wurden Vor- und Nachteile von verschiedenen Rendering-Arten besprochen. Die Empfehlung war: Hybrid Rendering, das nicht nur Client-seitig läuft, sondern auch zum Teil Server- seitig.

Der zweite Teil beschäftigte sich mit Mobile Performance und zwar ganz konkret mit der Grundsatzfrage, welche Smartphones überhaupt als Benchmark genutzt werden. Dies ändert sich bekannterweise von Jahr zu Jahr und ist bei vielen PageSpeed-Tools veraltet. Eine Lösung: Die Auswertung der meistgenutzten Smartphones in bestimmten Shops / Ländern über Google Analytics dient der mobilen Optimierung für relevante Modelle.

Amazon PPC: Von Strukturen zu programmatischen Kampagnen und Retargeting (Trutz Fries, Désirée-Sina Kellner)

Zunächst drehte sich alles um aktuelle Targeting-Möglichkeiten (wie Ausrichtung auf Produkte & Kategorien) und CPC-Gebotsoptimierung über die Amazon Sponsored Product Ads. Dann gab es spannende Insights zur Placement-Performance: 80% der Werbe-Impressionen erfolgen auf Produktdetailseiten, zum Teil performen obere Positionen auf der ersten Amazon-Suchergebnisseite jedoch besser. Deswegen ist es wichtig, sich strategisch gegenüber Wettbewerbern zu positionieren und eigene Produkte zu schützen.

Anschließend wurde Grundlegendes zur Amazon Demand Side Platform (DSP auf CPM-Basis / Programmatic Advertising) vorgestellt. Diese punktet u.a. mit Display im Lower Funnel und Kaufdaten. Zudem ist es über die DSP nicht nur möglich auf Amazon, sondern auch zum eigenen Shop zu verlinken – allerdings nicht von Amazon selbst. Es folgten Targeting-Basics wie die Ansprache von Amazon Nutzern, die relevante Produkte besucht haben, und Beispiele für Dynamic E-Commerce Ads im vertrauenserweckenden Look & Feel von Amazon. Die Strategie sollte dabei sein, je nach Phase der Customer Journey eine passende Werbeform zu wählen.

Diesmal wird es ernst: die Roboter kommen und alles wird sich ändern (Jim Sterne)

In dieser Keynote ging es vorrangig um AI Basics, wie die verschiedenen Typen von Machine Learning und automatisierbare Tätigkeiten. Der zentrale Ansatz von Jim Sterne war dabei die Optimierung für Customer to Business (CTB) Bot Negotiation. Unterhaltsam war seine Demonstration, wie ein Kunde zukünftig mit einem intelligenten Assistenten bzw. „Butler“ kommunizieren könnte.

Das Ende von Exact Match? Taktiken für die negative Keyword Automatisierung (Christopher Gutknecht)

Christopher Gutknecht stellte sieben Negativtaktiken inklusive Ansätze zur Automatisierung über Scripts vor. Viele Kampagnentypen und Keywords konkurrieren um dieselben Suchanfragen, wobei man dazu sagen muss, dass nahe Varianten dabei bisher nur einen kleinen Teil ausmachen. Gutknecht gab uns mit auf den Weg, dass man durch die Reduktion von Überlappung beim Suchanfragenfluss Kosten einsparen kann. Das Highlight des Vortrags waren die spannenden Code-Insights, welche dieses Takeaway direkt in der Praxis umsetzbar machen – Danke Christoph!

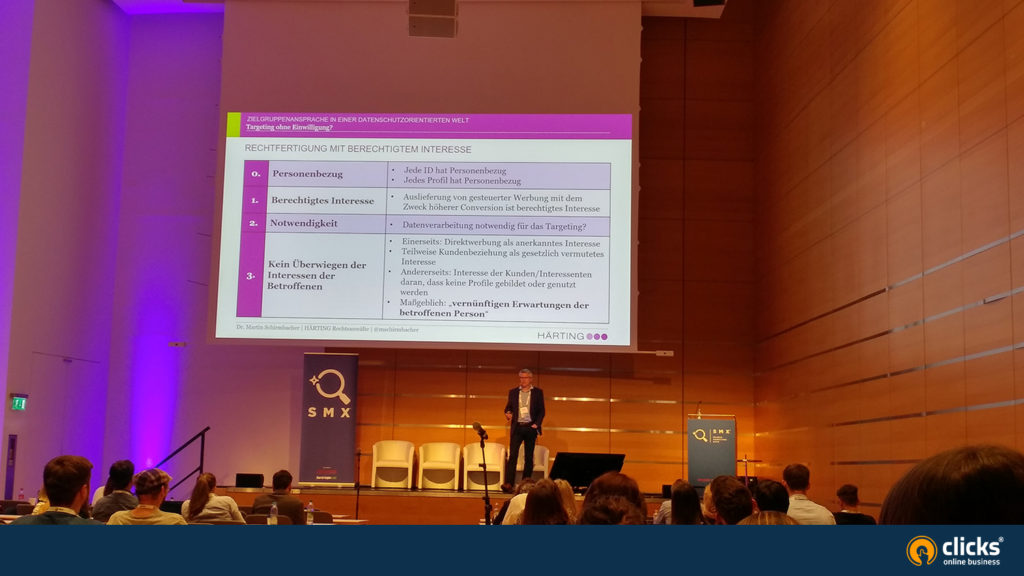

Zielgruppenansprache in einer datenschutzorientierten Welt (Dr. Martin Schirmbacher)

Hier wurden wir von Dr. Martin Schirmbacher juristisch noch einmal abgeholt, was den Datenschutz vs. der Zielgruppenansprache betrifft: Die Verarbeitung personenbezogener Daten ist verboten. Es sei denn, es liegt eine Nutzer-Einwilligung vor ODER ein Vertrag ODER ein berechtigtes Interesse. Positiv ist dabei, dass bei Direktwerbung ein berechtigtes Interesse bestehen kann. Tracking und Nutzer-Profiling erfordern laut der Positionsbestimmung der DSK hingegen eine Einwilligung. Das widerspricht wiederum der Klausel zum Widerspruchsrecht für Profiling (Opt-In vs. -Out). Das klingt recht kompliziert, aber maßgeblich ist die konkrete Targeting-Methode (vs. „vernünftige Wahrnehmung“ der Nutzer):

- Einfaches Retargeting ist ok, Cross Device wird es aber negativ (als „Verfolgung“) wahrgenommen.

- Custom Audiences über Kundenlisten (E-Mail-Upload) sind eindeutig rechtswidrig ohne vorherige Einwilligung (klare Rechtsentscheidung, zumal Facebook-Nutzer die Nutzung ihrer Daten durch Marken einsehen können > Finger weg!)

- Werbeaussteuerung über eigene (!) Nutzerprofile z.B. für Shop Werbung/Personalisierung ist hingegen vertretbar, solange diese nicht mit externen Daten angereichert werden.

Fazit: Durch den hohen Klärungsbedarf ist folgendes in der Praxis besonders wichtig: Dokumentation und Prüfung. Die erhobenen Daten und der Zweck der Datenverarbeitung müssen jeweils im Voraus festgelegt werden.

Fragt die SEA-Experten! (Brad Geddes, Martin Röttgerding, Frederick Vallaeys)

Bei dieser offenen Runde gab es kontroverse Fragen aus dem Publikum, z.B. warum sich Brand-Werbung zusätzlich zum organischen (Top) Ranking lohnt oder auch wie gut Googles Smart Bidding gegenüber anderen Bid Management Lösungen abschneidet. Spannend war auch die Frage, ob längere bzw. mehr Anzeigeninhalte automatisch besser performen. Das ist nur ein kleiner Auszug der Fragen von den Teilnehmern der SMX, mit denen sich aktuell jeder PPC-Manager beschäftigen sollte. Die Experten hatten auf jeden Fall passende Antworten parat!

Quantität vor Qualität? Human versus Machine? Ein Blick in die Blackbox der Automatisierung von Google Ads (Oliver Greifenstein, Oliver Zenglein)

Der erste Teil des Vortrags behandelte Geschäftsdatenfeeds, automatische Anzeigenanpassungen und Kampagnenerstellung auf Basis von Feedattributen. Angesprochen wurden zudem neue, smarte Kampagnentypen und responsive Anzeigenformate wie auch Vor- und Nachteile von Google Smart Bidding.

Der zweite Part ging spezifischer auf Google Shopping-Strategien ein, zum Beispiel den Kampagnen-Split nach Gerät oder Suchintention, (automatisierte) Kombination mit passenden Suchanzeigen, sowie die Anreicherung von Feeds um unternehmensspezifische Daten (wie die Marge je Produkt) für Gebotsstrategien.

Wenn die Technologie unser Leben bestimmt – Überlebensstrategien für eine neue Ära (Karl Gilis)

Die Keynote der SMX am zweiten Tag von Karl Gilis lässt sich in einem einzigen Hashtag zusammenfassen: #makeyourcustomershappy.

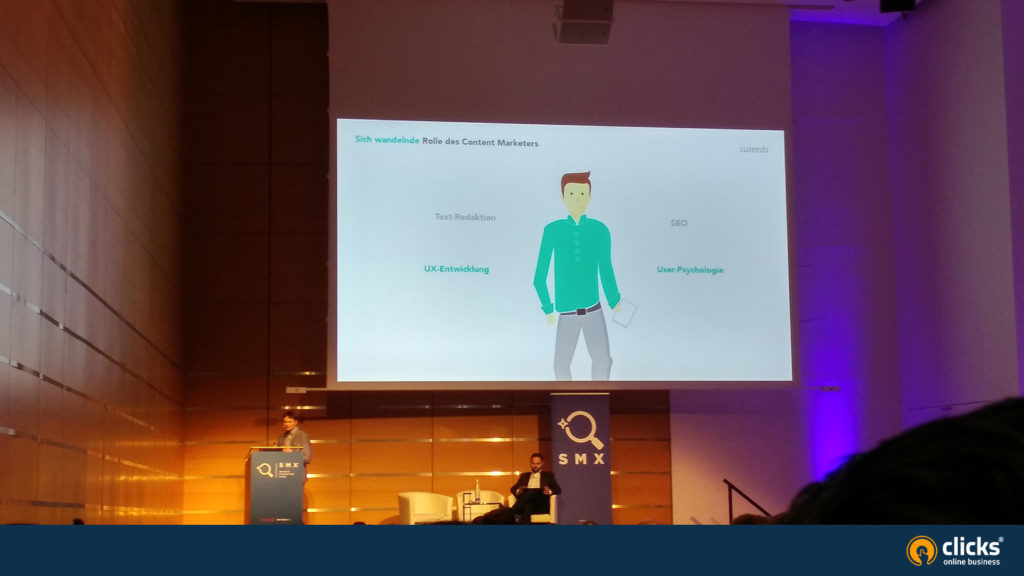

Was haben die anderen, was ich nicht habe? Die Macht der vergleichenden Content-Analyse – Benchmarking und Tools (Fionn Kientzler)

Der Vortrag drehte sich um die wandelnde Rolle eines Content Marketers. Diese sind schon lange nicht mehr nur Texter mit SEO-Wissen. Beim Content Marketing kommt es auch darauf an die Zielgruppen zu verstehen sowie sich strategisch an der UX Gestaltung zu beteiligen. Fionn Kietzler stellte dazu Benchmarking-Tools wie Sistrix, ahrefs, Advanced Web Ranking, SEMrush, Image Color Summarizer, LinkResearchTools, TermLabs.iO, SharedCount und PageSpeed Insights vor.

Die Learnings:

- Redaktionelles Scoring ist wichtig, um bspw. die ideale Tonalität festzustellen

- Nutzersignale wirken sich (vermutlich) auf das Ranking aus: hier ein Beispiel für guten Content mit Top-Rankings: https://www.liebscher-bracht.com/

- Qualitative Erhebungsmethode für UX Faktoren („Coding“ bzw. Scoring z.B. zur Bewertung der Filter-Usability)

- Meta- Description emotionalisieren und visualisieren, sich auch mal trauen weniger Text und mehr Whitespace auszuprobieren, um sich von der Textwand abzuheben

- Da, wo aktuell noch wenig deutschsprachiger Content oder Wettbewerber vorhanden sind, sollte man sich auch gern mal am US-Markt orientieren

Large Scale SEA – Prozess einer Inhouse Lösung (Rasmus Porsgaard)

Rasmus Porsgaard ist Co-Gründer von Holidu, einer Plattform, auf der über 14 Millionen Unterkünfte aus verschiedenen Quellen aggregiert werden – mit unterschiedlichen Saisonalitäten und Verfügbarkeiten. In der Praxis arbeitet diese mit einem riesigen Keyword-Set, das sich ständig ändert. Deswegen hat das Unternehmen eine skalierbare Lösung entwickelt. Warum? Die Excel Sheet Uploads sprengten in dieser Größenordnung den Rahmen des Möglichen mit Google Ads. Stattdessen testete man Drittanbieter-Lösungen, die den Anforderungen jedoch auch nicht gerecht wurden. Die Lösung: Eine Schulung von Developern in AdWords Basics gefolgt von der Entwicklung eines eigenen (regelbasierten) Tools zur Kampagnenerstellung über die eigene Datenbasis. Insgesamt dauerte es 18 Monate bis zum ersten Kampagnen-Launch, gefolgt von sechs Monaten Testing. Auch jetzt wird die Lösung kontinuierlich weiterentwickelt. Der Entwicklungsaufwand ist also nicht zu unterschätzen!

Recruiting 2020: Storytelling & Branding mit Social Ads (Yannick Lott)

Es herrscht nach wie vor Fachkräftemangel und in (fast) allen Bereichen sind mehr Stellenausschreibungen als Bewerber vorhanden. Heutzutage reicht das reine Arbeitsangebot daher nicht mehr aus. Die Unternehmen sind gefordert authentische Werte zu kommunizieren, welche die Bewerber abholen. Schlau ist derjenige, der die Nähe zur jungen Zielgruppe über soziale Kanäle sucht, und den richtigen Zeitpunkt abwartet, um den möglichen Bewerber anzusprechen – wenn dieser gerade unzufrieden ist. Wichtig ist zudem, dass Employer Branding und Recruiting Performance zusammenwachsen und ein gemeinsames Kommunikationskonzept über den gesamten Funnel entwickelt sowie umgesetzt werden sollte.

Yannick Lott warf als Beispiel die „Azubiwoche“ Kampagne für die Bahn in den Ring. Es gab jeden Tag anderen Content: Teaser, Videos von Ausbildungsstationen, FAQ-Videos, Interviews oder Livestreams sowie anschließend regional ausgespieltes Retargeting (zur Wiederansprache und Generierung von Bewerbungen für passende Ausbildungsstellen). Besonders interessant war, dass sie sogar erfolgreich auf Tinder Werbung gemacht haben nach dem Motto „Hier findest Du was Ernstes – Also beruflich.“

Sherlock Holmes der Daten oder die Kunst der Interpretation (Tom Alby)

In diesem Vortrag ging es um die richtige Interpretation erhobener Daten. Dazu gab es als Einführung Statistik-Basics wie Rechtsschiefe vs. Normalverteilung (weswegen Durchschnittswerte in Google Analytics oft nicht aussagekräftig sind). Zudem wurden die fehlerhafte Messung von Google Analytics Nutzerverhalten sowie falsche Interpretationen von Kreisdiagrammen (z.B. Neu vs. wiederkehrende Nutzer – denn diese können beiden Gruppen angehören, was die Daten verfälscht) aufgezeigt.

Fazit: Vorsicht walten lassen bei der Dateninterpretation, vor allem in hübsch aufbereiteten Tools, deren Funktionsweise man nicht im Detail kennt. Nur weil es gut aussieht, muss es nicht richtig sein.

Produktentwicklung mit Machine Learning und KI: Chancen und Herausforderungen (Shalini Sukumar)

Shalini Sukumar gab in ihrem Vortrag noch mal ein paar Machine Learning Basics zum Besten. Zum Beispiel, dass in der Produktentwicklung die Personalisierung je nach Nutzertyp erfolgen sollte, um das Produkt an den Nutzer und seinen Kontext anzupassen. Die Plattform Booking.com setzt dabei in der Praxis auf verschiedene A/B-Tests und Experimente mit den Learnings:

- Die Personalisierung sollte mit Bedacht und Vorsicht durchgeführt werden.

- Nutzer-Personas sollten kontinuierlich beobachtet, analysiert und dokumentiert werden.

- Der Nutzer sollte ausreichend Kontrolle behalten.

- Man sollte die eigenen Daten nutzen, aber sich ihrer Grenzen bewusst sein.

Technical Onpage & Onsite Clinic (Website Clinic m. John Müller)

John Müller von Google hat sich im Rahmen einer Website Clinic den Fragen des Publikums geöffnet. Dieses konnte vorab Seiten einreichen und Fragen zu den Projekten stellen. Neben einer ganzen Reihe Basics waren folgende Tipps & Hinweise recht interessant:

1. Hreflang-Tags können nach Sprache & Land vergeben werden. Dabei sollte man gut aufpassen, dass alle Eventualitäten abgedeckt werden. Beispiel: Eine Sprachversion wird mit de-DE für Deutsch in Deutschland gekennzeichnet. Gleichzeitig wird als Standardsprache (x-default) Englisch definiert. Sucht jemand mit deutschsprachigem Browser, der nicht eindeutig zur Region Deutschland zugeordnet werden kann, würde er die englische Webseite gezeigt bekommen. Es ist deshalb empfehlenswert, neben den detaillierten Tags zu Sprache & Region noch Tags einzusetzen, die nur die Sprache adressieren.

2. Google ignoriert teilweise regionale Varianten in den hreflang-Tags. Beispiel: Ein Seitenbetreiber unterscheidet die Bereiche domain.tld/de-CH und domain.tdl/de-DE. Hat Google jedoch das Gefühl, dass sich beide Seiten sehr stark ähneln, wird Google selbstständig eine Sprachvariante als die kanonische wählen und die andere wenig bis gar nicht im Index berücksichtigen.

Welche URLs Google als kanonisch identifiziert hängt an folgenden Faktoren:

- interne Verlinkung

- Angabe im rel canonical Tag

- externe Links

- Angaben in den Sitemaps

- Angaben in den hreflang Tags

- Länge der URL

Experiment SEO Kannibalisierung (Jason Paget, Ross Tavendale)

Jason Paget von booking.com stellte einen A/B Test vor, mit dem verschiedene Lösungsansätze für Duplicate Content Probleme getestet wurden. Für Singapur gibt es bspw. eine Stadt Landingpage, eine Länder Landingpage sowie eine Suchergebnisseite. Über tausende Seiten hinweg führen solche Dopplungen zu „guten Kannibalisierungen“, bei denen Doppelrankings in den Top 8 bestehen, die gut geklickt werden. Die These war: die Kannibalisierungen sind schlecht und verwirren Google; wenn Seiten zusammengefasst werden, gibt es eine super Seite, die noch bessere Rankings bekommt. Im Testszenario gab es eine Kontrollgruppe und eine Testgruppe: Die Kontrollgruppe behielt Doppelrankings und in der Testgruppe wurden nahe Duplikate mit Canonical versehen, sodass nur noch eine Seite im Index verblieb. Das Resultat: Die im Index verbliebenen Seiten der Testgruppe bekamen tatsächlich leicht bessere Rankings, allerdings war der Trafficverlust durch die verlorengegangenen Doppelrankings größer als die hinzugewonnenen Klicks.

Predictive SEO (Sebastian Erlhofer)

Suchmaschinenoptimierung kann heutzutage frustrierend sein: Das Erreichen der Top-Platzierung garantiert noch lange kein starkes Traffic Wachstum. Durch Anzeigen, SERP Features, direkt von Google beantwortete Fragen etc. sinkt der Anteil des Traffics, der auf fremde Seiten fließt von Jahr zu Jahr. Auf welche Keywords sollte sich ein SEO also fokussieren? Sebastian Erlhofer hat diese Frage mittels eines Machine Learning-Ansatzes beantwortet. Mittels Puppeteer wurde die Google Suche gecrawlt und dabei identifiziert, wie viele Anzeigen & SERP Features ausgespielt werden. Die Position jedes Elements wurde in px vom oberen Bildschirmrand kalkuliert, um zu identifizieren, welche Elemente above the fold stehen. Sämtliche Informationen wurden gemeinsam mit Daten aus der GSC zu Impressionen, Klicks & CTR für das Training eines Machine Learning-Models genutzt. Anschließend war das Model in der Lage sehr präzise vorherzusagen mit welcher Klickrate auf welchen SERP-Positionen zu rechnen ist-

SEO Prozessoptimierung & Automatisierung (Jens Fauldraht)

Get:traction setzt als Agentur durch und durch auf Automatisierung. Spannend waren die einführenden Gedanken: Was tun, wenn man als Agentur für Beratung auf Stundenbasis bezahlt wird, durch Automatisierung schlussendlich aber an einer Beschleunigung und damit an seinem eigenen Geschäftsmodell sägt? Die Antwort von Jens Fauldrath: Weg von Stundenpreisen hin zu Paketpreisen. Sein Tipp für den Alltag: mit kleinen Prozessen beginnen und nicht gleich die große eierlegende Wollmilchsau ins Visier nehmen. Jens Fauldraht stellte zudem unterschiedliche Prozesse vor, die in der Regel durch den Einsatz via R4Studio automatisiert wurden. Ausgewählte Tipps sind auch im get:traction Blog zu finden:

https://www.gettraction.de/blog/seo-indexeffizienz/

https://www.gettraction.de/blog/javascript-seo-screaming-frog-r-crawl-aufbereiten/

https://www.gettraction.de/blog/gettraction-snippet-generator/

Wer nicht programmieren kann / es lernen möchte, dem sei Knime empfohlen: hier lassen sich Prozesse über eine grafische Oberfläche automatisieren.

Erste Erkenntnisse zum Google March 2019 Core Update und Nichts geht ohne Daten: Dekonstruktion, Kreation und Einsatz von gutem Content (Marcus Tober)

Die Keywordsets & Seiten nach dem Mediq-Update und nach dem Core Update wurden verglichen: Nach dem Mediq-Update waren sehr klare Zusammenhänge zwischen Speed- Kennzahlen und Rankings zu erkennen. Dank ausgewählter Beispiele war nachvollziehbar, dass Seiten mit Newsletter Interstitial & Werbevideos mit hohem Gewicht verloren haben.Interessanterweise wurden diese Zusammenhänge nach dem Core-Update wieder stark durcheinander gewürfelt. Tatsächlich konnte Marcus Tober trotz der großen Datenmengen, über die Searchmetrics verfügt, keine gesicherte These herausarbeiten. Seine wichtigsten Beobachtungen waren:

- Mit dem Core Update haben vor allem im Gesundheitssektor Seiten mit hohem Trustfaktor Rankings zurückerobert, auch wenn hinsichtlich Ladezeit sowie aufdringlicher Werbung viele offene Baustellen existieren.

- Die Ergebnisse des Lighthouse-Checks sollten ernst genommen werden.

- Das Informationsbedürfnis des Kunden sollte ernst genommen werden.

So fand Katharina die diesjährige SMX

Die SMX München war wie immer gut besucht und mit zahlreichen und disziplinübergreifenden Vorträgen und Workshops gespickt. Die meisten Speaker hatten jedoch sehr viel Theorie, statt Praxis im Gepäck, so dass man sich eher Inspiration mitnahm, statt wirklich Umsetzbares. Für so eine große Veranstaltung hat die Organisation wieder gut geklappt. Im Vergleich zum Vorjahr gab es zum Beispiel kürzere Warteschlangen in den Mittagspausen.

Weitere Recaps der SMX München 2019

https://blog.bloofusion.de/smx-munchen-2019-recap-day1/

https://blog.bloofusion.de/smx-munchen-2019-recap-day2/

https://www.121watt.de/online-marketing/smx-recap/

https://www.luna-park.de/blog/33877-recap-smx-muenchen/

https://www.onlinesolutionsgroup.de/blog/smx-2019-recap/

https://www.netzgefaehrten.de/netzgefaehrten-smx-muenchen-2019-recap/

https://www.seo-profi-berlin.de/seo/blog/smx-muenchen.php

https://wortspiel.com/de/smx-muenchen

https://www.seoreviewtools.com/smx-2019-recap-top-3-sessions/

https://www.conblu.de/smx-2019-recap/

http://www.projecter.de/blog/events/so-war-die-smx-2019.html

Vielen Dank für die Aufnahme meines Vortrags in Euren Recap und die Verlinkung der Artikel. Habt ein Kaffee oder Bier gut, wenn Ihr mal in Berlin vorbeikommen wollt 😉

Werde auf dich zurückkommen 😉

Danke für die Infos.

Veranstaltung ist leider an mir vorbeigegangen… Der Beschreibung nach zu urteilen hat es sich gelohnt. Ich wäre sehr an Technical SEO / Onsite Clinic interessiert gewesen. schaaade ;-(